注意力机制(基于seq2seq RNN)详解

本节提出了注意力(Attention)机制,这是神经网络翻译的最新解决方案。

注意力的思想是 2015 年在论文“Neural Machine Translation by Jointly Learning to Align and Translate”(Dzmitry Bahdanau,Kyunghyun Cho和Yoshua Bengio,ICLR,2015)中提出的,它需要在编码器和解码器 RNN 之间增加额外的连接。事实上,仅将解码器与编码器的最新层连接会存在信息瓶颈,而且不一定能够传递先前编码器层的信息。

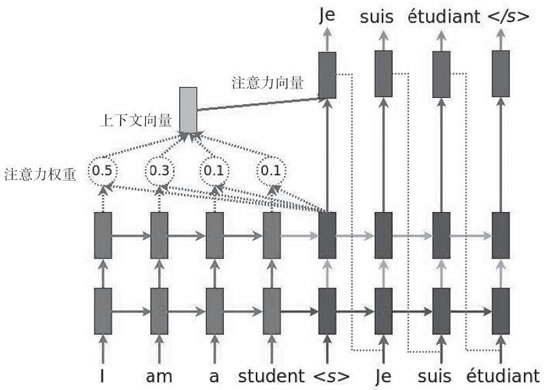

下图说明了采用注意力机制的方法:

发表评论